(中央社訊息服務20230103 11:28:03)人工智慧(Artificial Intelligence, AI)作為現代國家科技發展的基石,AI生命週期中資料應用的適法性、透明性、安全性等也成為國際上最關注的議題。財團法人資訊工業策進會科技法律研究所(資策會科法所)長期致力於關注重要國際組織、民主標竿國家之相關AI法制政策趨勢,規劃有助於AI發展的資料流通相關機制,以兼顧AI及資料治理,並期望能夠接軌國際。

觀察國際社會AI發展歷程,討論度最高的議題即在於,AI應用在促進經濟發展與社會正義、民主發展能否達到平衡?因此,如何建立合倫理、負責任之AI,並提高人民對於AI使用的信賴,成為AI發展至使用的先決條件。科法所副法律研究員許嘉芳表示,綜整目前國際社會發展可信賴AI之價值或原則內涵,大致可歸納為:(1)以人為本;(2)多元包容、公平與無歧視;(3)隱私與個人資料保護;(4)安全;(5)透明、可解釋;(6)可歸責;(7)永續發展等。目前國際社會針對可信賴AI規範,大多數仍是鼓勵AI系統生命週期各階段參與者,能夠自願遵守而不具法律拘束力。

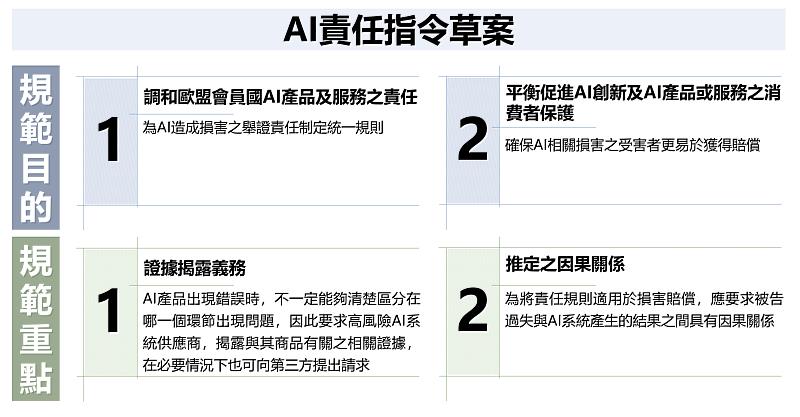

從近期國際趨勢觀察到,歐盟已出現突破性作為,除2021年提出《AI規則草案》外,又從貿易市場角度,就AI產品制定禁制性規範,於2022年9月接續提出《AI責任指令草案》,調整製造商對有缺陷的AI產品的嚴格法律責任,並為AI造成損害的舉證責任制定統一規則。該指令兩大規範重點:一、證據揭露義務,由於AI產品發生錯很難區分是哪一個環節出問題,故要求AI系統供應商需揭露與其商品有關的證據;二、推定的因果關係,由於AI系統較難明確指出損害來自哪些過失,因此採用因果關係推論來減輕受害者的舉證責任。

雖AI系統的類型、應用領域及應用目的非常多元,難以訂定普遍適用的AI倫理實質標準,仍可觀察出歐盟期望透過其貿易市場影響力,規劃從自主檢視朝向法律監管的可能性,以因應未來AI應用可能造成的風險與衝擊,並建構負責任的AI使用提升人民對該應用的信賴。許嘉芳表示,之前我國政府機關與民間企業AI研發應用偏向技術先行,針對負責任、可信賴AI思維僅於2019年2月由科技部(現國科會前身)提出「人工智慧科研發展指引」。但受到國際趨勢影響,特定產業領域逐漸開始意識到AI倫理議題的重要性,特別是自駕車、金融、醫療等備受民眾關注及主管機關高度監管的領域。因此,可信賴AI倫理發展及相關法制建構仍值得持續關注。

資策會科技法律研究所官方網站 https://stli.iii.org.tw/